Une équipe de chercheurs dirigée par Boyuan Chen à l’Université Duke a créé un cadre révolutionnaire appelé WildFusion, qui confère aux robots des capacités de perception semblables à celles des humains pour naviguer dans des environnements extérieurs difficiles.

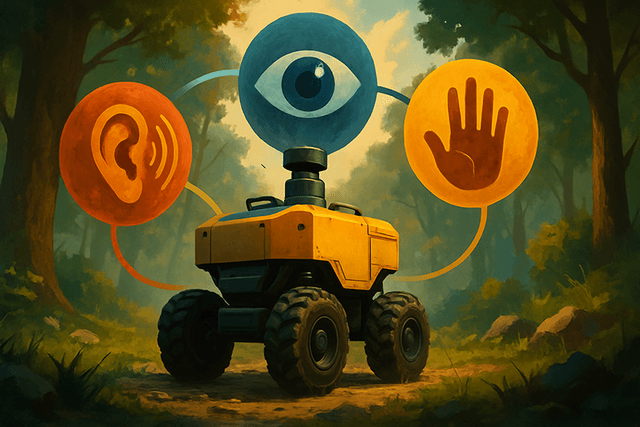

Contrairement aux robots conventionnels qui s’appuient uniquement sur les données visuelles provenant de caméras ou de LiDAR, WildFusion équipe un robot quadrupède de sens supplémentaires : le toucher et la vibration. Cette approche multisensorielle permet au robot de construire des cartes environnementales plus riches et de prendre de meilleures décisions quant aux chemins sûrs à emprunter sur des terrains complexes.

« WildFusion ouvre un nouveau chapitre dans la navigation robotique et la cartographie 3D », explique Boyuan Chen, professeur adjoint à l’Université Duke. « Cela aide les robots à opérer avec plus d’assurance dans des environnements non structurés et imprévisibles comme les forêts, les zones sinistrées et les terrains hors route. »

Le système fonctionne en intégrant les données de multiples capteurs. Des microphones de contact enregistrent les vibrations à chaque pas, permettant de distinguer des surfaces comme des feuilles craquantes ou de la boue molle. Des capteurs tactiles mesurent la pression exercée par les pattes pour détecter la stabilité, tandis que des capteurs inertiels suivent l’équilibre du robot. Toutes ces informations sont traitées par des encodeurs neuronaux spécialisés et fusionnées dans un modèle environnemental complet.

Au cœur de WildFusion se trouve une architecture d’apprentissage profond qui représente l’environnement comme un champ mathématique continu plutôt qu’une série de points déconnectés. Cela permet au robot de « combler les vides » lorsque les données des capteurs sont incomplètes, à l’image de la façon dont les humains naviguent intuitivement avec une information partielle.

La technologie a été testée avec succès au parc d’État Eno River en Caroline du Nord, où le robot a navigué avec assurance dans des forêts denses, des prairies et sur des sentiers de gravier. « Ces tests en conditions réelles ont démontré la remarquable capacité de WildFusion à prédire avec précision la franchissabilité du terrain », souligne Yanbaihui Liu, principal auteur étudiant.

Pour l’avenir, l’équipe prévoit d’intégrer des capteurs supplémentaires, comme des détecteurs thermiques et d’humidité, afin d’accroître encore la perception environnementale du robot. Grâce à sa conception modulaire, WildFusion offre de vastes possibilités d’application au-delà des sentiers forestiers, notamment en intervention lors de catastrophes, en surveillance environnementale, en agriculture et pour l’inspection d’infrastructures éloignées.