デューク大学のボーユアン・チェン氏率いる研究チームは、ロボットが困難な屋外環境をナビゲートするための人間のような知覚能力を持つ画期的なフレームワーク「WildFusion」を開発しました。

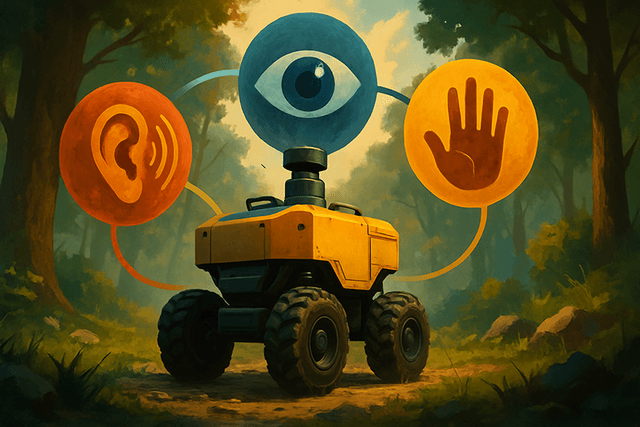

従来のロボットはカメラやLiDARなど視覚情報のみに頼ることが多いですが、WildFusionは四足歩行ロボットに触覚や振動感知の機能も搭載しています。このマルチセンサリーなアプローチにより、ロボットはより豊かな環境マップを構築し、複雑な地形でも安全な経路を的確に判断できるようになります。

「WildFusionはロボットのナビゲーションや3Dマッピングに新たな章をもたらします」と、デューク大学助教授のボーユアン・チェン氏は語ります。「森林や災害現場、オフロードなど、構造化されていない予測困難な環境でも、ロボットがより自信を持って行動できるようになります。」

このシステムは複数のセンサーからのデータを統合して動作します。接触用マイクロフォンは歩行時の振動を記録し、カサカサした落ち葉や柔らかい泥など、異なる地面を識別します。触覚センサーは足裏の圧力を測定して安定性を検知し、慣性センサーはロボットのバランスを追跡します。これらすべての情報は専用のニューラルエンコーダーで処理され、包括的な環境モデルに統合されます。

WildFusionの中核には、環境を離散的な点ではなく連続的な数学的フィールドとして表現するディープラーニングアーキテクチャがあります。これにより、センサーデータが不完全な場合でも、人間が直感的に「空白を埋める」ように、ロボットも状況を推測して進むことができます。

この技術はノースカロライナ州のエノ川州立公園で実証され、ロボットは密集した森林や草原、砂利道を自信を持ってナビゲートしました。「これらの実地試験で、WildFusionの優れた通行可能性予測能力が証明されました」と、筆頭学生著者のヤンバイフイ・リウ氏は述べています。

今後、研究チームは熱センサーや湿度センサーなどさらなるセンサーの追加を計画しており、ロボットの環境認識能力を一層高める方針です。モジュール設計のWildFusionは、森林トレイル以外にも災害対応、環境モニタリング、農業、遠隔インフラの点検など幅広い応用が期待されています。