듀크대학교의 천보위안(Boyuan Chen) 교수가 이끄는 연구팀이 야외의 험난한 환경을 탐색할 수 있도록 로봇에 인간과 유사한 지각 능력을 부여하는 혁신적 프레임워크 'WildFusion'을 개발했다.

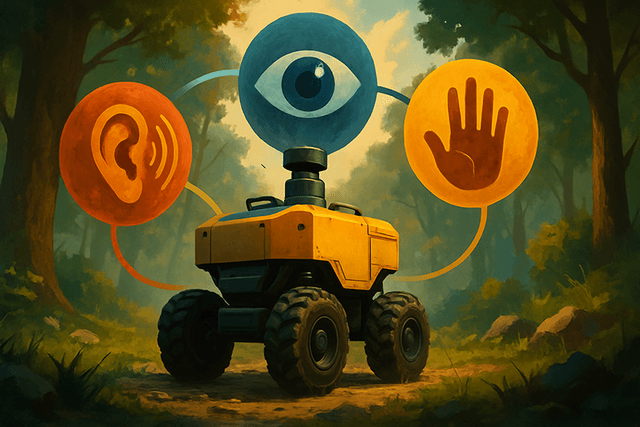

기존 로봇이 카메라나 라이다(LiDAR) 등 시각 정보에만 의존하는 것과 달리, WildFusion은 4족 로봇에 촉각과 진동 감지 기능을 추가했다. 이 다중 감각 접근법을 통해 로봇은 더 풍부한 환경 지도를 구축하고, 복잡한 지형에서 안전한 경로를 더 효과적으로 판단할 수 있다.

천보위안 교수는 "WildFusion은 로봇 내비게이션과 3D 매핑의 새로운 장을 열었다"며, "이 기술은 숲, 재난 현장, 비포장 지형 등 구조화되지 않고 예측 불가능한 환경에서 로봇이 더욱 자신감 있게 작동할 수 있도록 돕는다"고 설명했다.

WildFusion은 여러 센서의 데이터를 통합해 작동한다. 접촉 마이크는 로봇의 발걸음마다 발생하는 진동을 기록해 바삭거리는 낙엽, 부드러운 진흙 등 다양한 지면을 구분한다. 촉각 센서는 발의 압력을 측정해 안정성을 감지하고, 관성 센서는 로봇의 균형을 추적한다. 이 모든 정보는 특수 신경 인코더를 통해 처리되며, 통합된 환경 모델로 융합된다.

WildFusion의 핵심은 환경을 불연속적인 점이 아닌 연속적인 수학적 필드로 표현하는 딥러닝 구조다. 이를 통해 로봇은 센서 데이터가 일부 누락된 상황에서도 인간처럼 직관적으로 '빈틈을 채우며' 이동할 수 있다.

이 기술은 미국 노스캐롤라이나주 이노리버 주립공원(Eno River State Park)에서 실제로 테스트됐으며, 로봇은 울창한 숲, 초원, 자갈길 등 다양한 지형을 자신 있게 탐색했다. 논문의 제1저자인 류얀바이후이(Yanbaihui Liu)는 "실환경 테스트를 통해 WildFusion의 뛰어난 지형 예측 능력이 입증됐다"고 밝혔다.

연구팀은 앞으로 열 감지, 습도 센서 등 추가적인 센서를 도입해 로봇의 환경 인지 능력을 더욱 강화할 계획이다. 모듈형 설계 덕분에 WildFusion은 산림 탐사뿐 아니라 재난 대응, 환경 모니터링, 농업, 원격 인프라 점검 등 다양한 분야로의 확장 가능성이 크다.